大学、専門学校や企業などの研究室を訪問し、研究テーマや実験の様子をレポート

第27回 Part.3第27回 光センシングでVRやARの進化をめざす(3)

Part.3

バーチャル環境での

コミュニケーションを拡張

情報工学科 杉本 麻樹 准教授

公開:

更新:

VR(バーチャルリアリティ)という言葉はすでに一般的な用語として定着し、AR(オーグメンテッドリアリティ=拡張現実)という言葉も知られるようになってきた。では、いまVRやARによってどのようなことが可能になり、どのような研究が進められているのだろうか。今回は、センシング技術をベースにVRやARの進化に取り組んでいる慶應義塾大学の杉本麻樹先生の研究室を訪ねてみた。(Part.3/全4回)

Part.2「人の表情をリアルタイムでCGキャラクターに反映」はこちら

▲杉本 麻樹准教授

▲杉本 麻樹准教授

杉本先生に見せていただいた実験中の動画では、HMDの光センサーで計測しているのは目の部分だけだが、CGキャラクターの表情は実験している人と同じように口元なども動いている。これはどういうしくみなのだろうか。

「基本表情のテンプレートは、目の周辺だけでなく、口元などほかの部分も含むものになっていて、コンピュータにはその全体の表情を学習させています。

そのため、光センサーでは目のまわりから頬ぐらいまでを計測しているのですが、計測している部分の数値を基にして、口元などほかの部分がどのように動くのかを推定することができるようになっています。

基本的に人間の表情は、目のまわりがこう動くと口元などはこんなふうに動くというように連動した動きになりますから、顔全体を計測しなくても、ある程度、表情全体を推定することができ、それをCGキャラクターに反映させているということです」

この技術は、バーチャル環境でのコミュニケーションなどに活用していくことが想定されている。

「実世界では、離れた場所にいる人同士がリアルタイムで顔を見ながら会話できる遠隔会議システムが増えてきています。そうした豊富なリソースを活用して、ネットワーク上のバーチャル環境におけるソーシャルコミュニティにおいても、実在の人をCGキャラクターで表現し、それぞれの人がどんな表情で会話をしているのか、互いに知ることができるようにすることが可能になります。

また、VRゲームを複数の人が共同でプレイするような場合、それぞれの参加者が、ゲームがうまく進んで楽しそうにしているのか、困った顔をしているのかといったことを知ることで、ゲームをよりスムーズに協力しながらプレイすることもできるようになるのではないでしょうか。

このように、表情などの身体性を反映したキャラクターをつくることで、バーチャル環境の中での人と人のコミュニケーションの可能性を拡張していくことができるのではないかと思っています」

ウェアラブル・ロボットアームを

表情で操作する方法を検証

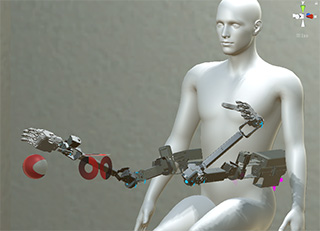

表情の研究で「身体性」というキーワードが出てきたが、杉本先生の研究室ではバーチャル環境を活用しながら人間の身体を拡張するための研究も進めている。

「現在、ウエアラブルロボット、つまり人間が身に付けるロボットを想定して、それをどのように操作するか、VRの環境でトライする研究に取り組んでいます。これは東京大学の稲見昌彦先生の研究室との共同研究のプロジェクトの一部です」

具体的には、人間の身体にロボットアームを2本加えて腕が4本になったら、そのロボットアームをどんなふうに操作できるのかということをVRの環境で検証しているそうだ。

「研究しているロボットアームは、稲見研究室が実際のハードウエアをつくっていて、アームの操作に足の動きを割り当てるという研究をしています。足を動かすことによって3本目・4本目の腕を自分自身が操作するしくみです。

操作に四肢の動きを割り当てると直感的に操作ができて便利なのですが、ナチュラルな身体ならではの問題もあります。たとえば、ダンボール箱を実際の両腕で抱えて歩いているようなシーンになると、腕や足でアームを操作すると、物体の把持や歩行などの動作が難しくなることもあります。

実際の腕とロボットアームが一緒に同じような作業をする場合だとやりやすいのですが、それぞれ独立した動きをしようとすると操作がしにくいということにもなるのです」

そこで杉本先生は、表情計測の技術を応用してロボットアームを操作することを考え、現在、その研究を進めている。

「我々は、身体を拡張したロボットアームの伸ばす、縮めるといった動きや、開く、つかむ、離すといったような動作に対して表情のコマンドを割り当てて、四肢の動きとは独立してロボットアームを制御することに取り組んでいます。

表情計測の研究と同様に、基本表情を使うのですが、そのコマンドだけだとロボットアームをどちらに向かせたいのかという問題が出てくるので、方向については顔の向きを使うようにしています」

「つもり操作」の技術によって

表情からアームの動きを生成

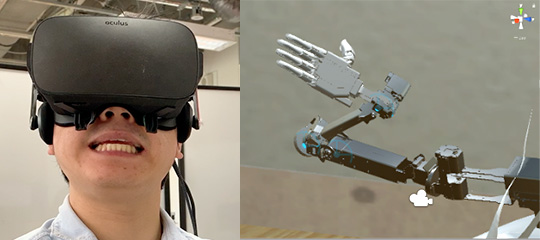

表情によってロボットアームを操作するということだが、それはどのようにすれば可能になるのか伺ってみた。

「つもり制御と呼ばれる技術があります。これは大阪大学の前田太郎先生が提案されているものです。

たとえば、ジョイスティックが手元にあるようなときに、操作する人にロボットのモーションを見せて、それをしている『つもり』でスティックを動かしてくださいという依頼をすると、ロボットの動きに対応した人間側の行動のデータセットが手に入ります。それをコンピュータに機械学習させることによって、ロボットの動きとスティックの操作を結び付け、スティック操作に対応したロボットの動きを生成していくことができるという概念です。

我々は、これを表情に適用しました。操作する人に、このロボットアームのモーションをしているつもりで表情をつくってくださいという依頼をします。そうしてロボットアームがこう動くときはこういう表情というデータを集めてコンピュータに機械学習させ、ロボットアームと表情の変化を結び付けて、表情によってロボットアームを操作できるようにしているのです」

腕に加えて2本のロボットアームがあれば、腕からロボットアームに荷物を渡して、それを腕では届きにくい場所に置くといった作業なども可能になる。

「いま、人工知能が人間の仕事を奪っていくのではないかといわれていますが、我々は、人間と機械の融合や共存を考えています。機械が人間と協調しながら一緒に作業をしたり、人間単独ではできないような機能性を機械で付加したりするなど、機械が人間の行動をサポートして身体機能を拡張していくことができれば、人間そのものを拡張することになると思います。

身体を拡張するロボットアームなどの機械をどのように操作すればいいのか。それをバーチャル環境の中で検証して、実用化の方法を探り、人間と機械の融合を実現することにつなげていきたいですね」

《つづく》